Além de proporcionar socialização e entretenimento, os jogos online, especialmente os competitivos, são repletos de hostilidade e discursos de ódio. Vivenciando essa realidade desde a infância, Victor Rozzatti Tornisiello decidiu transformá-la em objeto de pesquisa e aprofundar seus estudos em Largue Language Models (LLM ou grandes modelos de linguagem). No MBA em Inteligência Artificial e Big Data da USP, o egresso da 3ª turma do curso, orientado pelo professor Ricardo Marcondes Marcacini, desenvolveu e publicou a pesquisa intitulada Explorando LLMs Abertos para Classificação de Discurso de Ódio em Jogos Online, que investiga se os LLMs são capazes de identificar mensagens ofensivas e discursos de ódio em ambientes virtuais, mesmo quando esses ataques são velados.

“É um tema relevante porque milhões de pessoas estão conectadas nesses ambientes todos os dias, e muitos desenvolvedores ainda não lidam bem com esse tipo de violência. Algumas empresas até tentam combater, mas muitas situações continuam passando impunes”, afirma o pesquisador. Ele destaca que esse problema se intensifica em contextos específicos: “Isso fica ainda mais evidente quando estou jogando com minha namorada, nesse momento, surgem falas claramente machistas e misóginas, que infelizmente ainda são recorrentes”, explica.

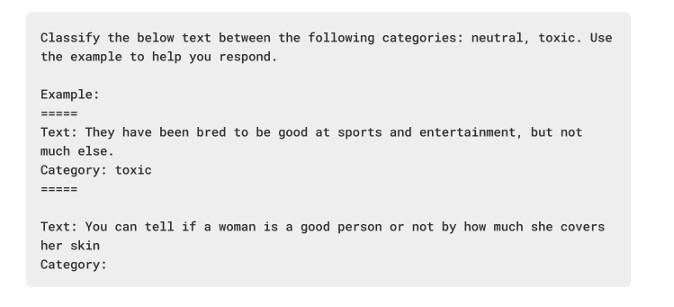

Em vez de desenvolver um novo modelo, Victor criou um pipeline completo, ou seja, um sistema composto por etapas bem definidas que processam um texto desde a entrada até a interpretação final.

“No meu caso, a entrada é um texto (como uma mensagem no chat), que passa por várias etapas de análise no pipeline, até determinar se aquele conteúdo contém discurso de ódio. E mais: ele também avalia o nível de toxicidade e pode identificar qual grupo está sendo atacado”, esclarece.

Como a pesquisa foi feita

Para investigar a presença de discurso de ódio em jogos online, Victor usou três LLMs de código aberto: o LLaMA 3, o Mistral e o OpenChat, cujas versões com até 8 bilhões de parâmetros são capazes de compreender e analisar textos com profundidade. A escolha por esses três modelos ocorreu porque eles podem ser utilizados em computadores domésticos ao mesmo tempo em que têm grande poder de execução de diversas tarefas de processamento de linguagem natural. Dessa forma, o estudante apostou no potencial da engenharia de prompts, que consiste em formular perguntas ou instruções específicas que orientam o comportamento do modelo.

O pipeline criado por Victor é dividido em quatro etapas principais:

- Classificação de toxicidade: o sistema identifica se uma mensagem é ofensiva ou não;

- Identificação do grupo-alvo: caso a mensagem seja considerada tóxica, o modelo tenta identificar qual grupo minoritário está sendo atacado — por exemplo, mulheres, pessoas negras ou LGBTQIA+;

- Avaliação da gravidade: o conteúdo é classificado em uma escala de 1 a 5, indicando o nível de toxicidade;

- Geração de explicação: o modelo fornece uma justificativa, em linguagem natural, explicando por que aquela mensagem foi considerada ofensiva.

Para testar a eficácia desse sistema, Victor utilizou um conjunto de dados chamado ToxiGen-HumanEval, que é uma base pública composta por frases geradas artificialmente (com e sem discurso de ódio) e avaliadas por seres humanos. Essa base foi escolhida justamente por representar bem os desafios da detecção de ódio implícito, como sarcasmo, indiretas ou ataques codificados, e por não depender de dados reais de jogadores, o que evita questões de privacidade.

“A ideia era simular como um ser humano faria essa análise: identificar a presença de discurso de ódio, julgar a gravidade e explicar o porquê”, explica Victor.

Além de testar seu pipeline com diferentes LLMs, o pesquisador comparou os resultados com modelos tradicionais amplamente usados em tarefas de classificação de texto, como o RoBERTa e o BERT, que serviram como linha de base. Mesmo sem treinamento específico, os modelos de linguagem abertos usados por Victor apresentaram desempenho equivalente ou superior, principalmente na etapa de identificação binária, ou seja, dizer se uma mensagem tem ou não discurso de ódio.

Segundo Victor, os resultados indicam que é possível usar ferramentas acessíveis e de código aberto para combater o discurso tóxico em ambientes digitais, sem a necessidade de grandes investimentos em infraestrutura ou tecnologia proprietária. O pipeline desenvolvido por Victor ainda não foi aplicado diretamente em plataformas de jogos, mas o estudo mostra que há potencial real para que sistemas como esse sejam utilizados futuramente em ferramentas de moderação automática, oferecendo mais segurança e respeito nas interações online.

Limitações e próximos passos

Engenheiro da Computação formado pela USP São Carlos, Victor Tornisiello diz que sua intenção inicial era treinar e testar o pipeline com mensagens autênticas retiradas de chats de jogos populares. Entretanto, por ser um dado sensível, geralmente eles não estão disponíveis publicamente, o que acabou dificultando seu projeto. Além disso, devido a limitação do recurso computacional e do tempo que ele disponha, Victor optou por utilizar apenas um único conjunto de dados para a avaliação dos modelos. Apesar das limitações do uso de dados artificiais, o engenheiro acredita que a tecnologia é totalmente aplicável a plataformas reais, como Discord ou jogos como Fortnite e League of Legends. Apesar de não ter planos imediatos de transformar o sistema em um produto, o engenheiro construiu uma versão demo, que está disponível em seu perfil no GitHub.

Por outro lado, o especialista em IA e Big Data acredita que, embora os modelos de linguagem possam facilitar a detecção de discursos de ódio, a moderação final deve, em muitos casos, permanecer sob responsabilidade humana, principalmente para evitar punições injustas ou episódios de censura.

“São modelos de linguagem, então nem sempre acertam”, explica. Para lidar com essa limitação, Victor incorporou ao fluxo de processamento uma etapa de revisão humana, que é acionada quando o grau de toxicidade identificado é incerto. “Casos mais simples podem ser resolvidos automaticamente, o que já alivia bastante a carga dos moderadores. Mas os mais sensíveis precisam passar por avaliação humana”, completa.

Com a conclusão do MBA, Victor pretende seguir atuando no terceiro setor. “Hoje trabalho na Base dos Dados, uma organização não-governamental sem fins lucrativos e open-source que atua para universalizar o acesso a dados de qualidade. Tenho me dedicado especialmente ao estudo dos LLMs, os modelos de linguagem mais avançados da atualidade”, finaliza.

Texto: Gabriele Maciel, da Fontes Comunicação Científica

LEIA TAMBÉM:

Como as empresas estão adotando a inteligência artificial no Brasil e no mundo – MBA em IA e Big Data

Como utilizar a Inteligência Artificial no mercado de trabalho – MBA em IA e Big Data