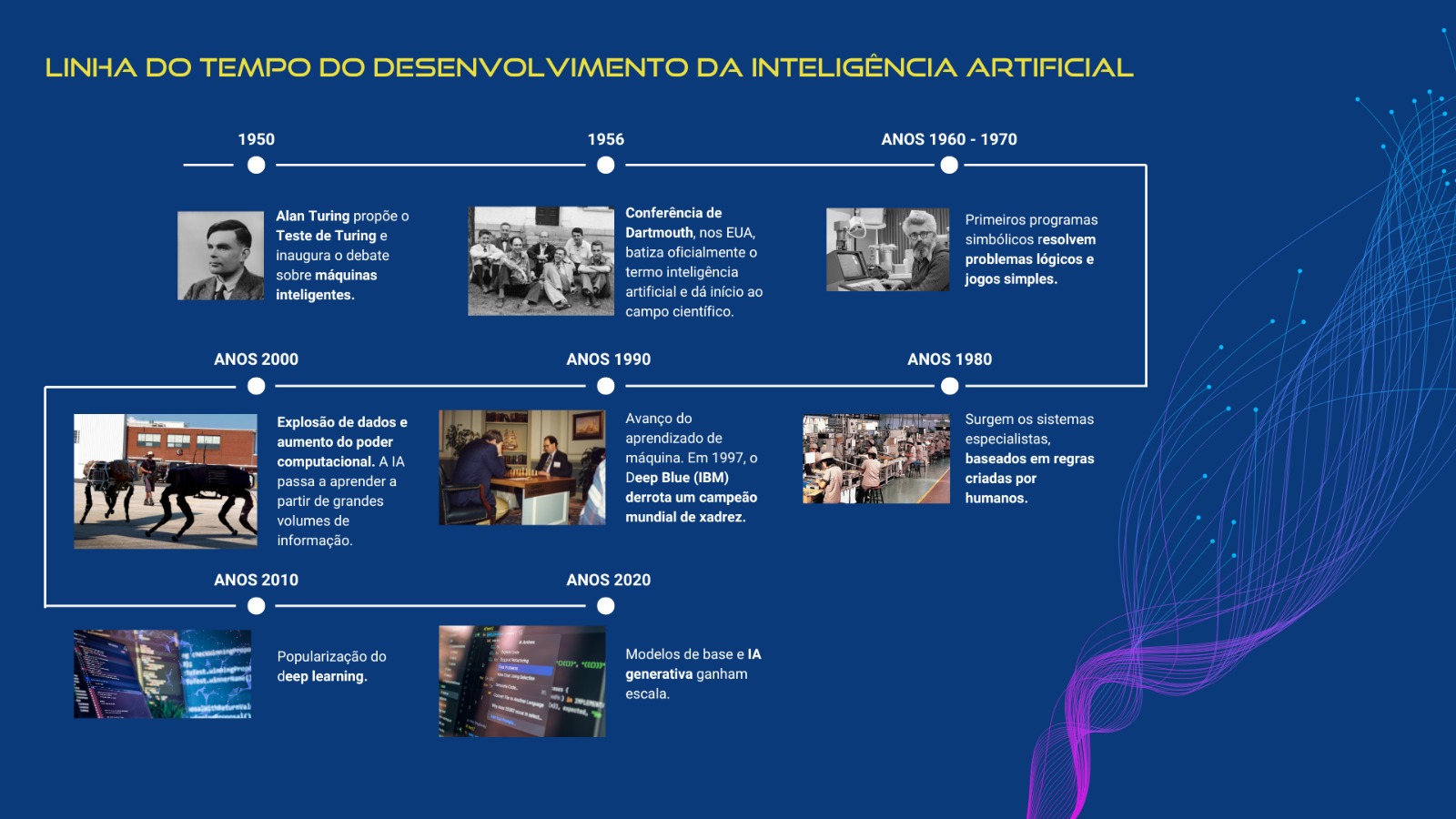

A inteligência artificial (IA) como hoje conhecemos não é resultado de uma ideia esplêndida saída de uma mente brilhante. Ao contrário, ela é resultado de um longo processo de amadurecimento, que envolveu menos uma marcha triunfal e mais uma sucessão de tentativas, que chegaram, inclusive, a um período de estagnação.

Tudo começa bem antes dos computadores. Em 1950, o matemático britânico Alan Turing publica o artigo Máquinas computacionais e inteligência, no qual lança a pergunta que se tornaria fundacional para o campo: Máquinas podem pensar?

Para responder a essa questão, ele sugere um experimento prático, chamado Jogo da Imitação ou, como ficou conhecido, Teste de Turing. Nele, um homem tenta adivinhar, a partir das respostas de um questionário, se está conversando com um homem ou com uma mulher. Depois, o homem é substituído por uma máquina. Se o humano não consegue distinguir, ele propõe que essa máquina poderia ser considerada inteligente. A provocação serviu para levantar o debate sobre máquinas que pensam e com isso, inaugurar um campo inteiro de pesquisa.

Seis anos depois, em 1956, pesquisadores se reúnem no Dartmouth College, nos Estados Unidos, para um workshop de verão que cunharia oficialmente o termo inteligência artificial (IA). A proposta, liderada por nomes como John McCarthy e Marvin Minsky, era que, em poucas décadas, seria possível reproduzir o raciocínio humano em máquinas. A partir dali, o campo passa a se dividir em duas grandes correntes de pensamento. De um lado estavam os simbolistas, que defendiam que a inteligência poderia ser reproduzida por meio da manipulação explícita de símbolos e regras lógicas. Para esse grupo, pensar era essencialmente seguir instruções bem definidas. Bastaria traduzir o conhecimento humano em estruturas formais, como árvores lógicas, axiomas e sistemas de inferência, para que a máquina pudesse raciocinar.

Do outro lado surgem os conexionistas, inspirados, ainda que de forma simplificada, no funcionamento do cérebro humano. Em vez de regras explícitas, eles propunham modelos baseados em redes de unidades interconectadas, capazes de aprender a partir de exemplos. A inteligência, nesse caso, não estaria previamente programada, mas emergiria do ajuste progressivo dessas conexões. Foi essa ideia que deu origem às redes neurais, que são a base da IA como hoje conhecemos. Entretanto, esse modelo foi visto com desconfiança, em parte por limitações computacionais, em parte por dificuldades teóricas.

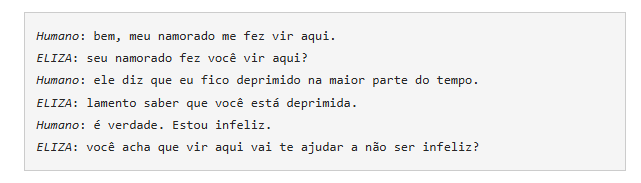

Ainda na década de 1960, um chatbot chamado ELIZA ganha o mundo. Ela funcionava a partir de uma máquina gigante e respondia com base em palavras chave.

A história da inteligência artificial avançou justamente na tensão entre essas duas visões, que continuam, até hoje, a moldar o desenvolvimento de sistemas cada vez mais complexos.

Invernos da IA

Nos anos 1970 e 1980, os chamados sistemas especialistas, que derivaram dos simbólicos, dominaram o debate. Eram programas baseados em regras explícitas, escritas por humanos, que tentavam capturar o conhecimento de especialistas em áreas como medicina e engenharia. Funcionavam bem em ambientes controlados, mas falhavam diante da complexidade do mundo real. O resultado foi um período conhecido como inverno da IA, marcado por cortes de financiamento e ceticismo acadêmico.

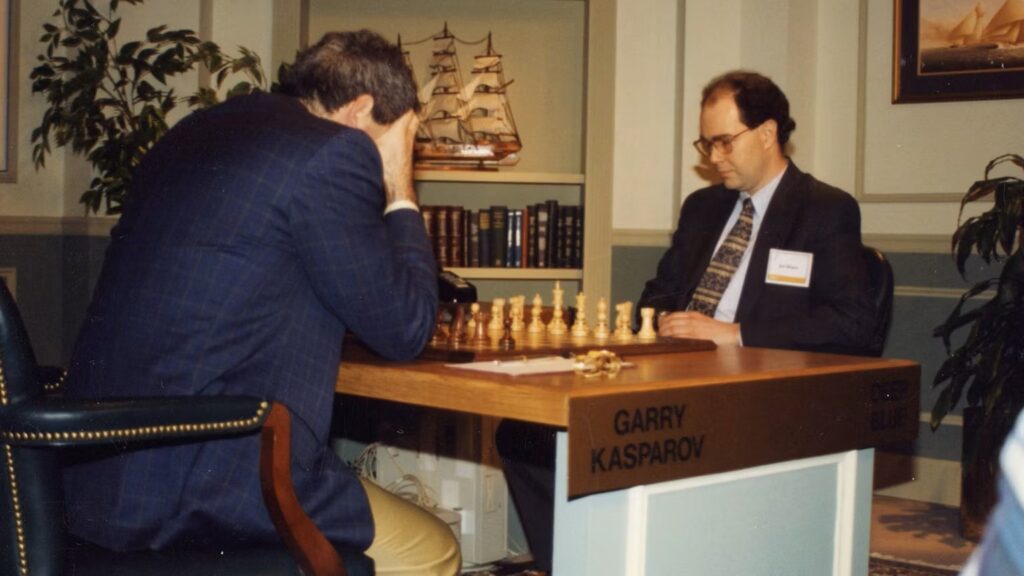

A virada começa a se desenhar nos anos 1990, quando o foco se desloca das regras para os dados. Em vez de dizer à máquina como pensar, pesquisadores passam a permitir que ela aprenda padrões a partir de exemplos. É o avanço do aprendizado de máquina. Em 1997, o supercomputador Deep Blue, da IBM, derrota o campeão mundial de xadrez Garry Kasparov. O feito não indica inteligência geral, mas demonstra a força de algoritmos estatísticos aliados à grande capacidade de processamento.

O salto seguinte acontece já no século 21, impulsionado por três fatores combinados:

- Mais dados, graças à internet e à digitalização da vida;

- Mais poder computacional, especialmente com o uso de GPUs;

- Novos modelos matemáticos, inspirados de forma distante no funcionamento do cérebro humano.

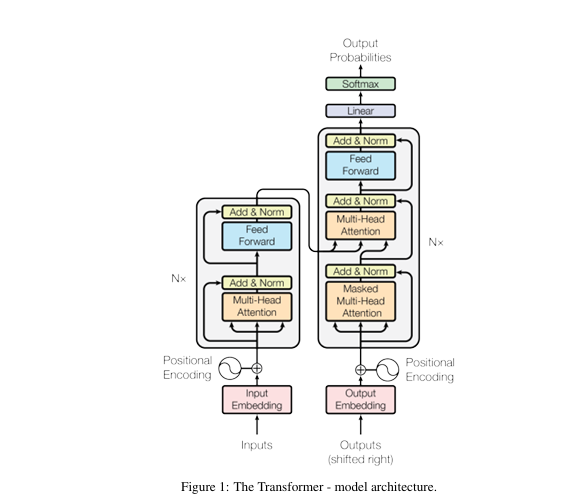

Em 2017, o Google lançou o artigo Atenção é tudo o que você precisa, apresentando o Transformer, um tipo de rede neural que mudou a forma como as máquinas processam a linguagem. O modelo aprende o contexto das palavras ao ajustar dinamicamente os pesos de atenção, identificando relações semânticas mesmo entre termos distantes no texto. Essa característica deu origem ao Large Language Models (LLMs).

A partir da ideia dos grandes modelos de linguagem, a OpenAI, empresa responsável pelo ChatGPT, treina seus sistemas com volumes gigantescos de textos, incluindo livros ainda não publicados. Ao tentar prever a próxima palavra de uma sequência, o modelo passou a demonstrar habilidades inesperadas, como responder perguntas, manter diálogos coerentes e articular informações de diferentes contextos. Em 2022 a empresa lança então o Chat GPT 1, abrindo a fronteira para o uso de IA em diferentes contextos.

Com esse lançamento, e suas versões posteriores, a ética no uso dessa inteligência passa a ser uma preocupação. Viés algorítmico, opacidade dos modelos, uso indevido de dados e impactos no mercado de trabalho entram definitivamente na agenda pública e científica.

Agora, quando o olhar se volta para o futuro, o consenso entre especialistas é menos triunfalista do que costuma parecer. Há quem defenda que estamos nos aproximando de uma inteligência artificial generalista, capaz de executar uma ampla gama de tarefas e, em alguns aspectos, rivalizar com habilidades humanas. Ainda assim, não há clareza sobre como esse patamar seria efetivamente alcançado. Persistem desafios estruturais, como a redução dos custos de desenvolvimento, a necessidade de infraestruturas computacionais mais eficientes e a diminuição dos impactos ambientais associados ao treinamento de grandes modelos.

Mais do que dominar ferramentas, torna-se essencial formar profissionais que saibam escolher quais técnicas empregar e em que contextos, na busca por soluções para problemas complexos, com rigor técnico, senso crítico e responsabilidade social – valores que hoje orientam a formação do MBA em IA e Big Data da USP.

Matéria: Gabriele Maciel, da Fontes Comunicação Científica